Qu’est-ce que la correction de biais ?

Les simulations des modèles climatiques ne peuvent pas être utilisées directement dans les études d’impact et les analyses de risque car elles comportent des erreurs systématiques (biais) par rapport aux observations.

Par exemple, les modèles climatiques ont souvent trop de jours de pluie et ont tendance à sous-estimer les précipitations extrêmes. Il peut y avoir des erreurs dans la quantité de précipitations saisonnières, et dans les températures qui peuvent être constamment trop élevées ou trop basses.

Les erreurs systématiques dans les modèles climatiques proviennent de leur résolution spatiale limitée (grandes tailles de grille), des conditions initiales, des processus physiques et thermodynamiques simplifiés ou d’une compréhension incomplète du système climatique dans son ensemble. Ces biais peuvent être problématiques car l’utilisation de données biaisées va à son tour produire des simulations ou des indicateurs biaisées et qui ne correspondent pas à la réalité.

Afin de réduire ces biais, des méthodes dites de correction de biais ont été développés. Pour l’ensemble de ces méthodes, il est important de mentionner que la qualité des données d’observation détermine la qualité de la correction de biais, notamment pour les extrêmes de précipitation qui requièrent des ensembles de données d’observation à long terme.

Les deux ensembles de données :

- Un ensemble de données d’observations que l’on considère non biaisée et que l’on appellera obs.

- Un ensemble de données provenant d’un modèle climatique à corriger (et donc biaisé) qu’on appellera mod.

Les ensembles de données obs et mod recouvrent une période historique commune de référence (ref).

L’objectif des méthodes de correction de biais est d’utiliser l’ensemble des données d’observation et des modèles climatiques sur la période de référence obsref pour identifier les facteurs correctifs à appliquer aux données modref. Ces facteurs correctifs sont par la suite appliqués aux données des modèles climatiques sur la période future, période pour laquelle les données d’observations ne sont pas disponibles.

Les types de méthodes statistiques

Il existe plusieurs types de méthodes statistiques pour pallier aux biais inhérents des modèles climatiques pour les études d’impact. Elles peuvent être regroupées en deux grandes familles basées sur des paradigmes différents :

Ces méthodes sont basées sur l’utilisation d’un facteur de changement, le « Delta », qui est le rapport entre une valeur moyenne de la simulation du modèle climatique sur la période future et celle sur la période historique de référence. Ce facteur de changement est ensuite appliqué aux données d’observation pour transformer ces données en données représentatives du climat du futur.

Ces méthodes reposent sur l’hypothèse que le facteur de changement dans la distribution des observations entre la période historique de référence et la période future sera le même que celui du modèle climatique.

Dans la méthode classique du delta change, la transformation des données historiques n’utilise que des variations des valeurs moyennes. Cependant, pour les évaluations du risque de crue par exemple, pour lesquelles des événements de précipitations extrêmes sont très importants, les évolutions des extrêmes, qui peuvent être différentes de celles de la moyenne, doivent être pris en compte.

La méthode avancée du delta change consiste en une transformation non linéaire des données de précipitations historiques. La méthode avancée prend en compte les changements des valeurs moyennes et extrêmes, pour extraire les signal climatique des simulations du modèle climatique. Ce signal climatique est par la suite appliqué aux données historiques d’observation pour créer un jeu transformé de données futures.

Les méthodes de correction de biais consistent à estimer un facteur de correction établit entre les données d’observation et les données simulées par le modèle climatique sur la période historique de référence. Une fois estimé, le facteur de correction est appliqué aux données simulées par le modèle climatique sur la période future, afin de créer des données corrigées de climat futur qui peuvent être alors prise en compte dans des études d’impacts.

Ces méthodes reposent sur l’hypothèse de stationnarité temporelle, c’est-à-dire supposent que la distribution statistique des données reste inchangée dans le temps. C’est une hypothèse forte qui ne tient pas compte de l’évolution du climat en contexte de changement climatique, mais qui reste largement utilisée par la communauté scientifique car elle permet de simplifier drastiquement les méthodes de correction de biais.

Il existe différents types de méthodes de correction de biais en fonction de la nature du facteur de correction. Les méthodes les plus simples reposent sur des facteurs de correction basés sur la moyenne, les méthodes plus sophistiquées appliquent un facteur de correction pour corriger la distribution statistique des données simulées par le modèle climatique.

C’est le cas par exemple des méthodes quantile-quantile (Q-Q), quantile mapping ou CDF-t qui consistent à estimer le facteur de correction en fonction des quantiles de la distribution de probabilité de la variable en question. Plus récemment, les méthodes de correction de biais basées sur du Machine Learning ou Deep Learning apparaissent.

exemples

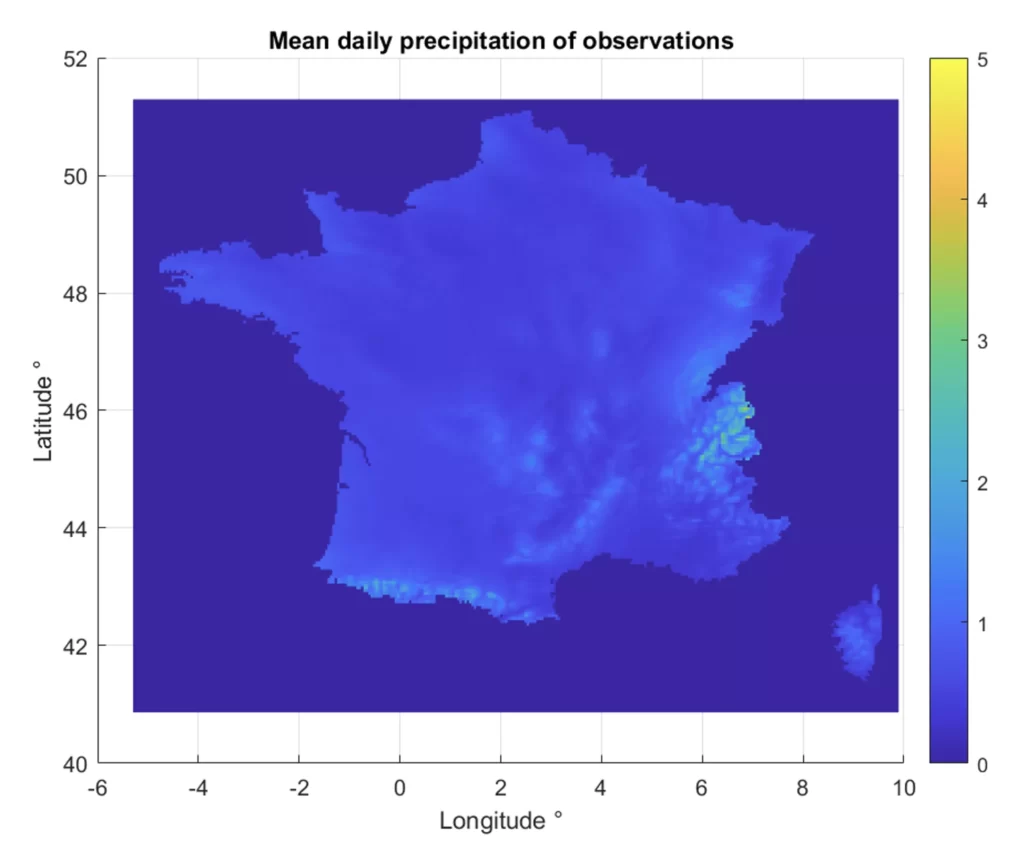

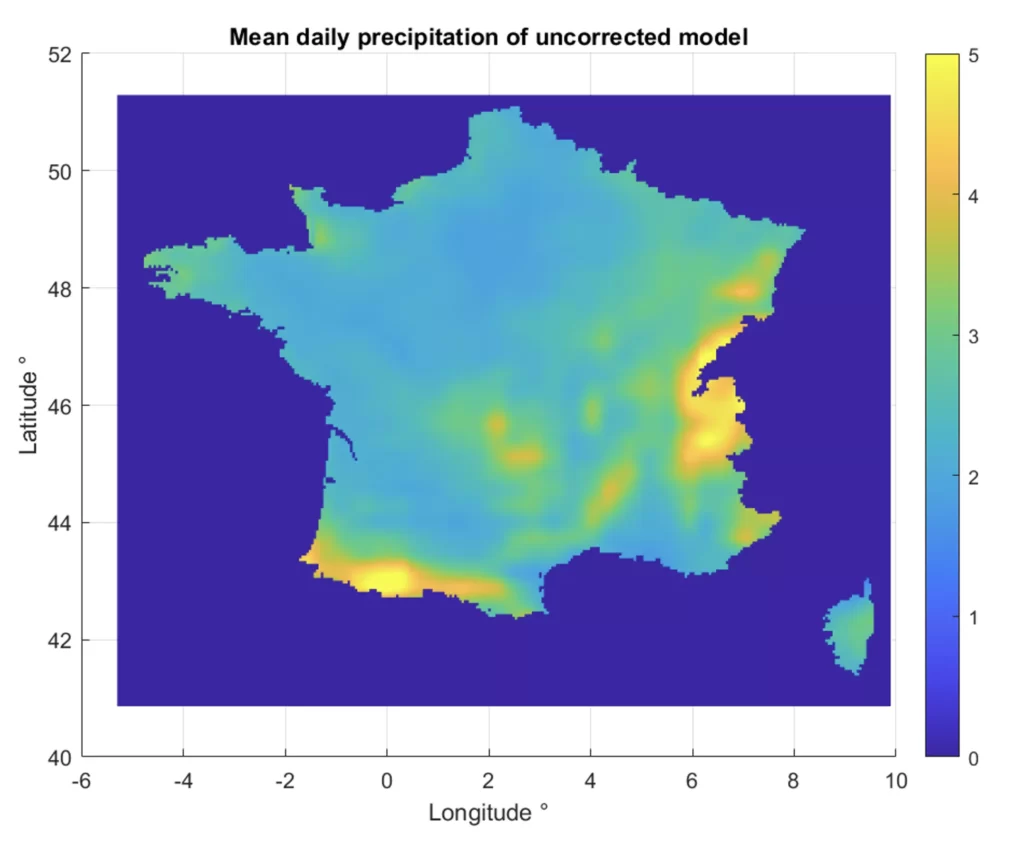

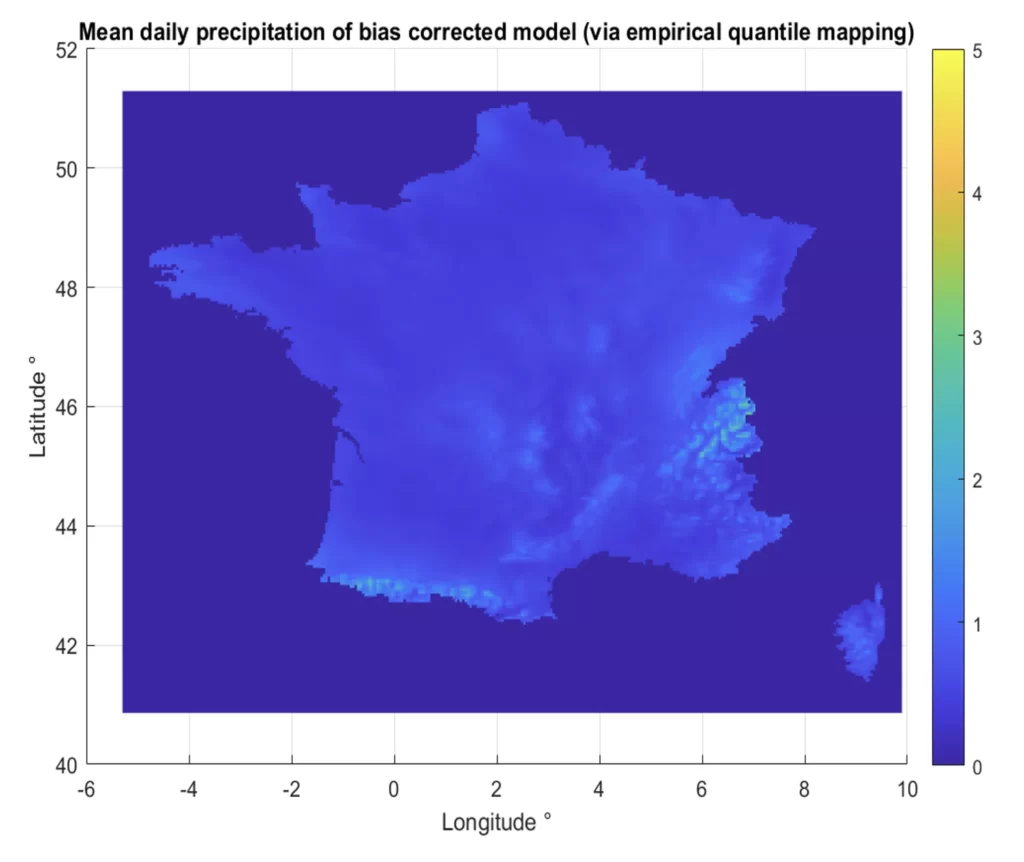

Prenons l’exemple d’un modèle climatique surestimant la moyenne des précipitations quotidiennes observées en France (Figures 1 et 2).

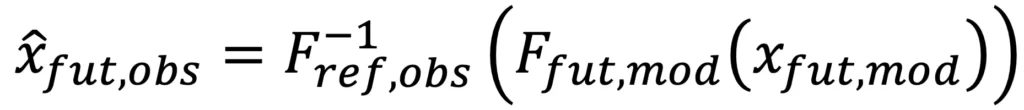

La méthode de quantile mapping s’exprime de la façon suivante :

Les données simulées du modèle climatique sont corrigées avec la distribution des observations sur la période de référence. Nous obtenons alors des données simulées corrigées semblables aux réelles observations (Figures 1 et 3), avec des différences dans les valeurs moyennes proches de 0.

Les méthodes de correction de biais peuvent être combinées avec les approches de descente à l’échelle.